Das Internet ist heute weder aus dem privaten noch dem beruflichen Umfeld wegzudenken: Was als Forschungsnetzwerk für wenige Fachleute begann, ist heute ein unverzichtbares Informations- und Kommunikationsmedium für die Gesamtbevölkerung – und damit ein wichtiger wirtschaftlicher Faktor. Dabei ist das World Wide Web erst seit 1993 kommerziell nutzbar.

Die Erfindung des Internets

Das Internet ist ein weltweites Computernetzwerk. Heute ermöglicht es die Nutzung verschiedener Dienste wie z. B. des World Wide Web (WWW) – das ist der allgemein zugängliche Bereich des Internets für Websites. Zudem werden Angebote wie Internettelefonie, E-Mail, Chat und Dateiübertragung über das Netz bereitgestellt.

Welche Bedeutung das Internet bis heute erlangt hat, zeigen die folgenden Zahlen:

Ein Satellit gibt den Anstoß

Die Grundidee des Internets entsteht in den 1950er-Jahren: Als 1957 die Sowjetunion den Satelliten Sputnik ins All schießt, sieht das US-Verteidigungsministerium darin eine potenzielle Bedrohung für das amerikanische Nachrichtensystem. Als Konsequenz soll ein computergesteuertes System entwickelt werden, das aus mehreren Knoten besteht und auch bei Ausfall eines dieser Knoten weiterhin funktioniert.

Mit der Koordination der Forschung wird die 1958 gegründete ARPA betraut (Advanced Research Project Agency – deutsch etwa: Behörde für fortgeschrittene Forschungsprojekte). Heute heißt sie DARPA, das D steht für Defence, also Verteidigung. Ziel der Behörde ist es damals, den technischen Rückstand auf die Sowjetunion aufzuholen. Die Arbeit der beteiligten Forschungseinrichtungen nimmt einige Jahre in Anspruch und bringt den Vorgänger des heutigen Internets hervor.

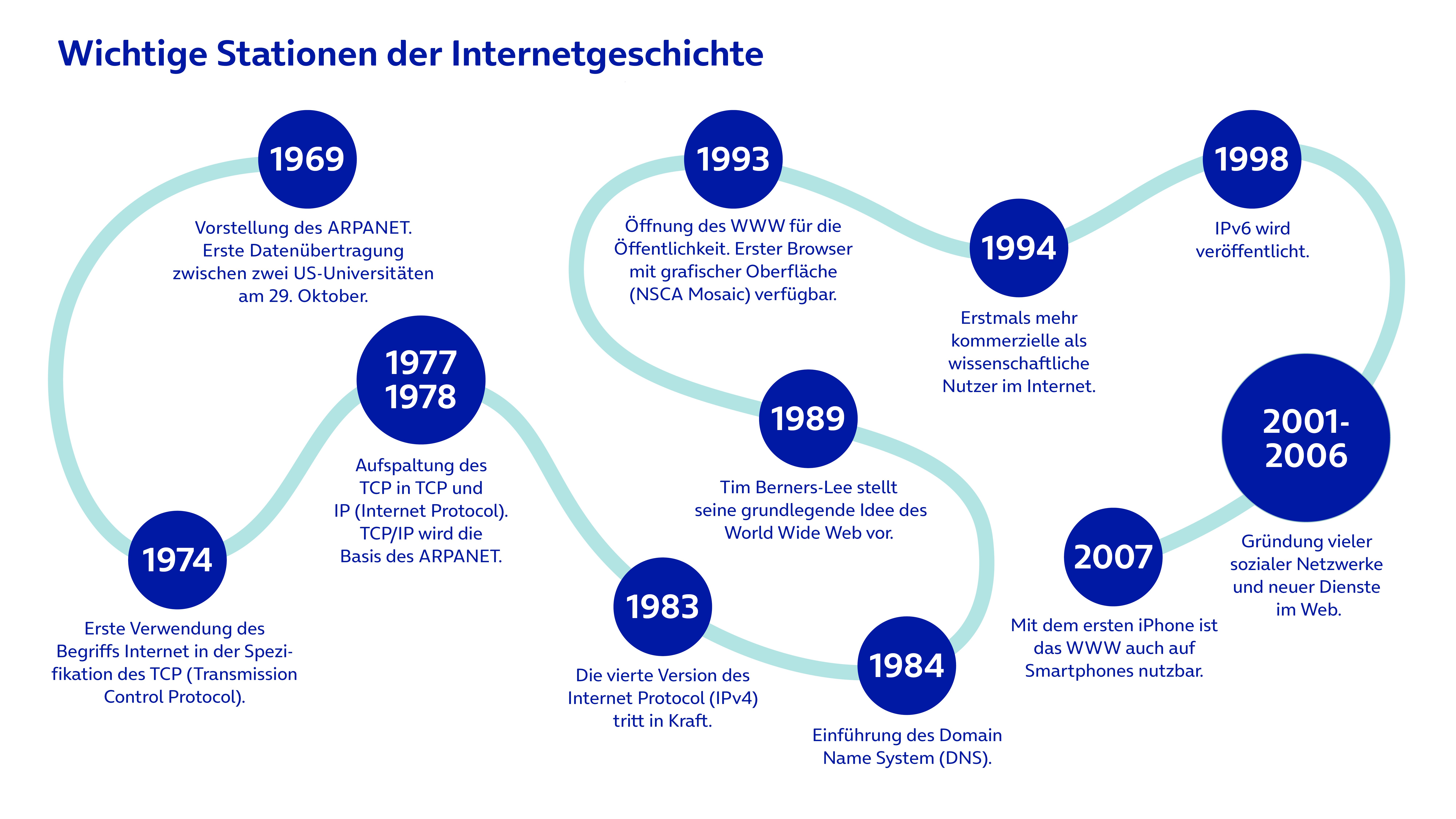

Die Entwicklung des Internets von den Anfängen bis heute

1960er-Jahre: Militär und Universitäten entwickeln das ARPANET

Die ARPA beginnt Ende der 1950er-Jahre in den USA ihre Arbeit und lässt das dezentral aufgebaute ARPANET entwickeln. Am Anfang ist es ein rein militärisches Projekt. Ab 1965 erhalten auch einige Universitäten Zugang zu dem Forschungsprojekt, das schließlich Ende des Jahrzehnts der Öffentlichkeit vorgestellt wird. Die erste Datenübertragung zwischen zwei Knoten des Netzwerks findet am 29. Oktober 1969 statt.

Zu diesem Zeitpunkt besteht das Netz aus vier miteinander verbundenen Rechnern. Diese befinden sich an der University of California Los Angeles, dem Stanford Research Institute, der University of California Santa Barbara und der University of Utah.

In dieser Entwicklungsphase werden die Grundlagen für das Internet gelegt, es wird für erste Anwendungen vorbereitet. Treibende Kräfte der Entwicklung sind einerseits militärische Interessen des US-Verteidigungsministeriums, andererseits der Wunsch nach einem schnellen und effizienten Datenaustausch in der Wissenschaft und an Universitäten.

Die dezentrale Organisation und das Prinzip der Übermittlung von Datenpaketen finden sich noch im heutigen Internet. Allerdings nutzt das ARPANET damals andere Protokolle für diese Zwecke.

1970er-Jahre: Entwicklung des TCP/IP

Bereits im Jahr 1971 besteht das ARPANET aus 15 Knoten und wächst langsam, aber stetig weiter.

Anfang der 1970er-Jahre gelingt zudem die erste Verbindung des ARPANET mit einem anderen Netzwerk – dem ALOHAnet der Universität Hawaii. Der Prozess wird als Inter-Networking bekannt. Da die damaligen Netzwerke jeweils unterschiedliche Schnittstellen, Paketgrößen, Übertragungsraten und Kennzeichnungen nutzen, ist eine Verbindung unter ihnen schwierig.

Gelöst wird dieses Problem 1973: Die US-Informatiker Vinton Cerf und Robert Kahn entwickeln das Transmission Control Protocol (TCP). Dieses neue Protokoll basiert auf dem französischen Projekt CYCLADES (der französischen Antwort auf das ARPANET). In den Spezifikationen des TCP wird im folgenden Jahr das erste Mal der Begriff Internet verwendet.

Wenige Jahre später und nach einigen weiteren Iterationen des Protokolls wird es in TCP und IP (Internet Protocol) aufgespalten. Dieser TCP/IP-Ansatz bildet noch heute die Grundlage des Datenaustauschs über das Internet.

1980er-Jahre: Der Name Internet setzt sich durch

1983 tritt die noch heute verwendete vierte Version des Internet Protocol in Kraft (IPv4). Damit setzt sich auch die Bezeichnung Internet durch.

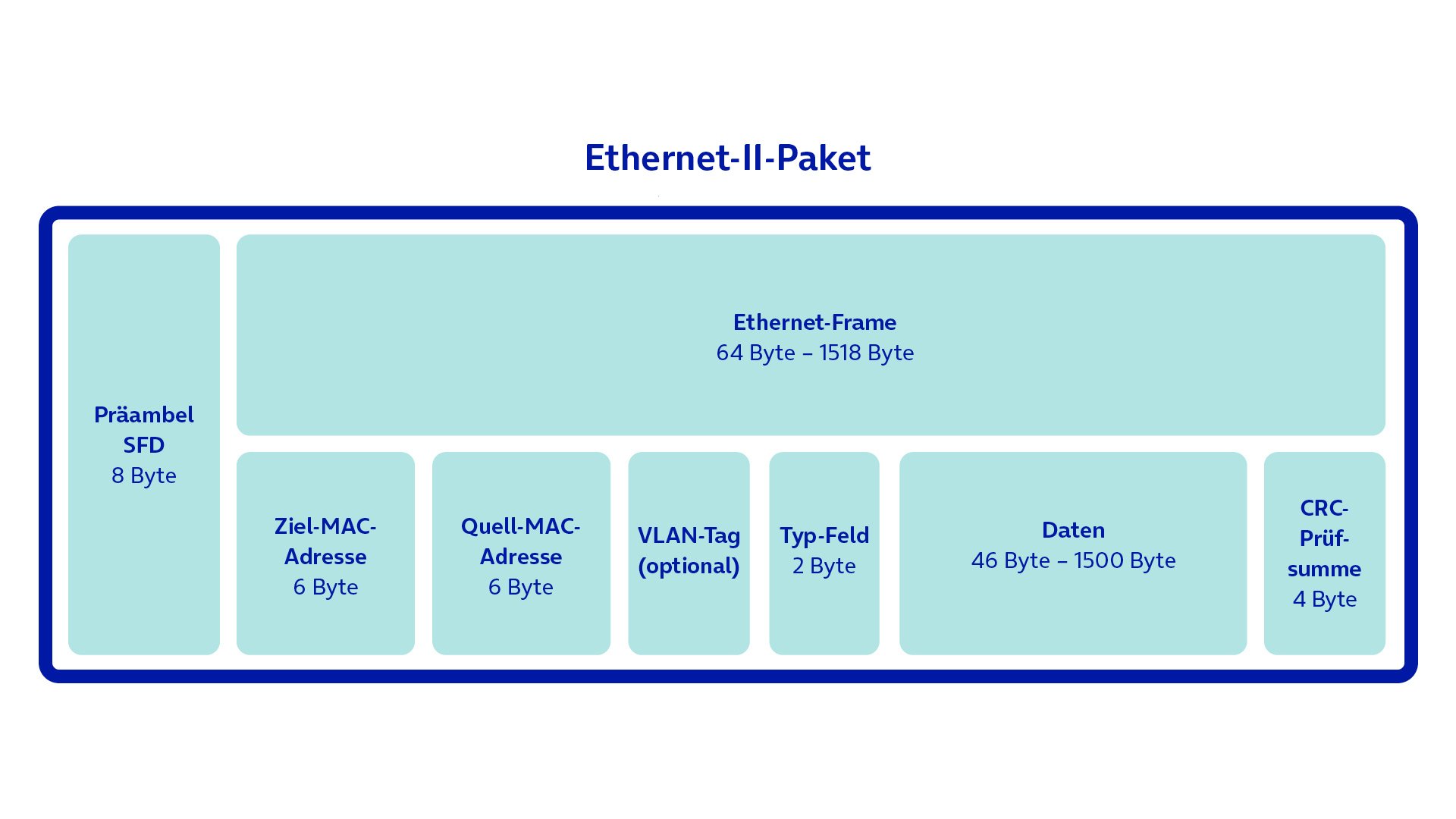

Eine wichtige Entwicklung dieser Zeit ist das Ethernet als neue Form des lokalen Computernetzwerks. Bereits in den 1970er-Jahren entwickelt, wird es in den 1980ern standardisiert und treibt im Verbund mit TCP/IP die Ausbreitung des Internets stark voran.

Einen weiteren entscheidenden Meilenstein in der Geschichte des Internets bildet die Entwicklung des Domain Name System (DNS) im Jahr 1984. Dieses System ermöglicht es auch heute noch, Rechner mit einfach zu merkenden Domainnamen anstatt mit komplizierten, bis zu zwölfstelligen IP-Adressen anzusteuern. Ein DNS-Dienst sucht daraufhin in einer Datenbank nach der zugehörigen IP-Adresse und leitet die Anfrage an den richtigen Rechner im Internet weiter.

Diese Technik findet auch im heutigen WWW Anwendung: Anstatt sich z. B. 141.101.90.99 zu merken und einzutippen, gibt man einfach o2business.de in die Adresszeile des Browsers ein und erreicht so den Server und die darauf gehostete Website.

1990er-Jahre: Das World Wide Web entsteht

1990 beschließt die US-amerikanische National Science Foundation, das Internet auch für kommerzielle Zwecke zu öffnen. Bis dato ist es ausschließlich als Forschungsnetzwerk und für militärische Zwecke genutzt worden. Nun sollen auch Privatpersonen darauf zugreifen können. Im selben Jahr geht das ARPANET außer Betrieb.

Vor allem die Erfindungen des britischen Physikers und Informatikers Tim Berners-Lee bereiten den Weg für das World Wide Web und tragen zu dessen rasanter Verbreitung bei. Die Idee eines weltweiten Hypertext-Netzwerks hat er bereits 1989 vorgestellt. Während seiner Zeit am europäischen Kernforschungszentrum CERN entwickelt Berners-Lee u. a.:

Die Auszeichnungssprache HTML (Hypertext Markup Language), auf der heute noch alle Webseiten im WWW basieren.

Das Protokoll HTTP (Hypertext Transfer Protocol), das das Aufrufen von Webseiten und die Navigation über Links ermöglicht.

Die URL (Uniform Resource Locator), die die Adresse einer Datei oder Webseite auf einem Server angibt.

Den ersten Webserver (info.cern.ch), den er 1991 auf seinem Computer einrichtet.

Den Webbrowser – sein Modell ist allerdings weniger erfolgreich als der grafische Browser Mosaic, den Marc Andreessen und Eric Bina 1993 am NSCA entwickeln (National Center for Supercomputing Applications).

Damit stehen die Grundpfeiler des WWW. Am 30. April 1993 gibt das CERN das World Wide Web kostenlos für die Öffentlichkeit frei.

Es folgt ein starkes Wachstum und viele Internetfirmen gründen sich.

1994:

Die Suchmaschinen Lycos und Yahoo sind verfügbar.

Die Zahl der kommerziellen Nutzerinnen und Nutzer übersteigt erstmals die der wissenschaftlichen – rund drei Millionen Rechner sind an das Internet angeschlossen.

Das Unternehmen Amazon gründet sich.

1997:

Rund sechs Millionen Computer sind mit dem Internet verbunden.

1998:

Das Internetprotokoll IPv6 wird veröffentlicht, um der steigenden Zahl von Geräten im Internet weiterhin IP-Adressen zuweisen zu können.

Das Unternehmen Google wird gegründet und die gleichnamige Suchmaschine geht online.

2000er-Jahre: Web 2.0

Das neue Jahrtausend beginnt mit einem Börsencrash – dem sogenannten Platzen der Dotcomblase. Viele Internetfirmen melden Insolvenz an und die erste Hochphase des Internets endet.

Dennoch steigt die Zahl der Nutzerinnen und Nutzer weiter an und es beginnt die zweite Hochphase, die auch als Web 2.0 bekannt ist. Dabei spielen weniger technische Neuerungen eine Rolle. Es geht eher um eine veränderte Nutzung und Wahrnehmung des Internets und des World Wide Web. Neue Webseiten, Dienste und Anwendungen entstehen, die unser Leben noch heute beeinflussen. Dazu zählen etwa:

Wikipedia (2001)

Facebook (2004)

YouTube (2005)

Twitter (2006, heute X)

Durch die sozialen Netzwerke gewinnt das WWW weiter an Bedeutung – sowohl im privaten als auch im politischen und wirtschaftlichen Bereich. Dazu trägt auch eine Entwicklung bei, die heute nahezu jede Person besitzt: das Smartphone.

Heute: Schnelles mobiles Internet

2007 erscheint das erste iPhone. Die bahnbrechende Neuerung damals: Es handelt sich um ein Mobiltelefon, mit dem man im Web surfen kann. In der Folge schreitet die Entwicklung der Smartphones schnell voran. Mit diesen vielseitigen Handys wächst der Bedarf der Menschen an neuer Technik. Gleichzeitig gibt es immer mehr technologische Möglichkeiten.

Heute ist schnelles mobiles Internet dank Mobilfunktechnologien wie LTE und 5G Standalone für nahezu alle Menschen verfügbar. Durch ausgereifte Smartphones ist das Internet und besonders das WWW für viele Personen zu einem Alltagsmedium geworden – im Privaten wie im Beruflichen.

Ein Blick in die Zukunft

Schauen wir noch einmal auf die Zahlen, die eingangs zur Sprache kamen:

80 % der Deutschen nutzen das Internet täglich, 95 % zumindest selten.

Nahezu 100 % der 14- bis 49-Jährigen sind Internetnutzer.

Eine weitere Steigerung dieser Zahlen scheint kaum möglich. Gleichzeitig sehen Experten voraus, dass sich menschliche Aktivitäten noch weiter in den digitalen Raum verlagern werden. Hier sollten besonders Unternehmen aufmerksam werden – um ihre Kunden auch in Zukunft zu erreichen, benötigen sie einen ansprechenden Internetauftritt.

Schlüsseltechnologien der Zukunft

Ein wichtiges Themengebiet ist Experten zufolge das Internet der Dinge (IoT), das künftig weiter anwachsen und an Bedeutung gewinnen wird. Besonders in Industrie und Produktion, aber auch in anderen Branchen werden Automatisierung und Digitalisierung demnach zunehmend wettbewerbsentscheidend.

Weiterhin rechnen Fachleute mit einem starken Bedeutungszuwachs bei Technologien wie Augmented Reality (AR) und Virtual Reality (VR). Außerdem wird die Mobilität der Zukunft mit z. B. autonomen Fahrzeugen eine wichtige Rolle spielen.

Als technische Treiber der weiteren Entwicklung des Internets sehen Analysten u. a. Technologien wie Blockchainund künstliche Intelligenz (KI).

Die Geschichte des Internets im Überblick

In den 1950er- und 1960er-Jahren entsteht mit dem ARPANET der Vorgänger des Internets.

Die 1970er und 1980er bringen grundlegende Entwicklungen hervor, die noch heute im Internet zum Einsatz kommen. Dazu gehören z. B. das Protokoll TCP/IP und das Ethernet.

Die 1990er-Jahre sind die Geburtsstunde des World Wide Web (WWW) als Dienst innerhalb des Internets. Nachdem die Öffentlichkeit 1993 Zugang zum WWW erhält, wächst es sehr rasch.

In den frühen 2000er-Jahren entstehen soziale Netzwerke – die Bedeutung des Internets (insbesondere des WWW) steigt weiter. Heute ist es das wahrscheinlich wichtigste Medium für viele Menschen.

Auch in Zukunft wird sich das Internet weiterentwickeln und neue Technologien werden an Bedeutung gewinnen. Die gesellschaftliche und wirtschaftliche Relevanz des Internets wird dadurch mutmaßlich weiter steigen.

Quelle:

https://www.o2business.de/magazin/geschichte-des-internets/